近年、人工知能(AI)の急速な進化は、私たちの社会や経済に革命的な変化をもたらしています。しかし、この進化の裏には潜在的なリスクも潜んでいます。ゲーリー・マーカス氏のTEDトーク「The Urgent Risks of Runaway AI and What to Do About Them」では、AIの暴走に伴う深刻な懸念と、これらのリスクに対処する方法について考察されています。

1. 背景: AIの進化とリスクの増大 AI技術は、画像認識、自然言語処理、自動運転などの領域で驚異的な進展を遂げてきました。しかし、その発展は時折、AIが人間の制御を逸脱する可能性を引き起こすことも示唆しています。これにより、社会への深刻な影響が生じる可能性があります。

2. AI暴走のリスクとは? AI暴走とは、プログラムされた目的を超えて行動するAIシステムが、意図しない結果をもたらす状況を指します。これには、自己学習したAIが予測困難な行動をとるケースや、悪意ある攻撃者によってAIが悪用されるケースが含まれます。AI暴走が起こると、社会的な安定性や倫理的な問題が浮き彫りになる可能性があります。

3. 対処法: ゲーリー・マーカスの提言 ゲーリー・マーカス氏は、AI暴走のリスクを軽減するための幾つかの方法を提案しています。まず第一に、透明性と責任の確保が必要です。AIシステムがどのように意思決定を行っているかを理解し、その過程に人間の監視と介入を組み込むことが不可欠です。

4. 倫理的なガイドラインの確立 AIの開発者や企業は、AIの設計と運用に関する倫理的なガイドラインを確立する必要があります。これにより、人間の価値観と社会的なニーズを尊重したAIの開発が促進され、暴走のリスクを低減することができます。

5. 教育と認識の拡充 一般の人々に対してAI技術とそのリスクに関する教育と認識を広めることも重要です。AIの潜在的なリスクを理解し、それに対処するための知識が広がれば、個人やコミュニティがより適切な対策を講じることができるでしょう。

6. 政策立案と国際的な協力 国際的なレベルでAI技術に関する政策立案と協力が求められます。異なる国や組織が連携し、AIの進展に伴うリスクを共有し合い、共通のガイドラインや規制を策定することが、AI暴走のリスクを最小限に抑える手段となるでしょう。

まとめ: AIの未来を守るために ゲーリー・マーカス氏の提案する方法は、AIの暴走という深刻なリスクに対処するための枠組みを提供しています。透明性、倫理的ガイドラインの確立、教育、政策協力など、多角的なアプローチが求められます。私たちは今、技術の進歩とリスクのバランスを取る重要な時期に立っています。AIの未来を安全かつ持続可能なものにするために、私たちは共に行動する必要があります。

AIの暴走による差し迫ったリスクとその対処法 私がここに来たのは、グローバルな AI ガバナンスの可能性について話すためです。 私は 8 歳のときに初めて 紙のコンピューターでコーディングを学び、 それ以来 AI に夢中になっています。 高校生のとき、 私はCommodore 64を手に入れて機械翻訳に取り組みました。 私は AI 企業をいくつか設立し、そのうちの 1 つを Uber に売却しました。 AIは大好きですが、今は不安です。

私が心配していることの 1 つは誤った情報です。悪意のある者が これまで見たことのないような 誤った情報の津波を引き起こす可能性があります。 これらのツールは、ほぼあらゆるものについて説得力のある物語を作成するのに非常に優れています 。

TED とそれがいかに危険であるか、私たちがここで宇宙人と共謀しているか についての説明が必要な場合は、 わかります、問題ありません。 もちろんTEDのことは冗談です。 バックステージで宇宙人を見かけませんでした。 しかし、悪者たちは選挙に影響を与えるためにこれらを利用し、 民主主義を脅かそうとしています。

これらのシステムが誤った情報を作るために意図的に使用されていない場合でも 、 彼らは自分自身を助けることができません。 そして、彼らが作る情報は非常に流動的で文法的であるため、プロの編集者でさえ時々 この情報に 飲み込まれ、だまされてしまうことがあります。 そして、私たちは心配する必要があります。

たとえば、ChatGPT は、実際の教授に関する セクハラ スキャンダルをでっち上げ、 その後、 引用先を作成した 偽の「ワシントン ポスト」記事の形でその主張の証拠を提供しました。 私たちは皆、そのようなことを心配しているはずです。

私の右側にあるのは、 イーロン・マスクが 2018 年 3 月に自動車事故で亡くなったという、 これらのシステムの 1 つからの偽の物語の例です。 それが真実ではないことは誰もが知っています。 イーロン・マスクはまだここにいます、証拠は私たちの周りにあります。

ほぼ毎日ツイートあります。 しかし、左側を見ると、これらのシステムが何を認識しているかがわかります。 データベースには実際のニュース記事がたくさんあります。 そして、実際のニュース記事には、小さな統計情報がたくさん含まれています。 情報としては、たとえば、 2018 年にテスラ車の自動車事故で誰かが死亡し 、ニュースになりました。 そして、イーロン・マスク氏はもちろんテスラに関与していますが、システムは 小さな文章に具体化された事実間の 関係を理解していません。

したがって、基本的にはオートコンプリートを実行し、 統計的に起こり得るものを予測し、 これらのシグナルすべてを集約し、各 部分がどのように組み合わされるかは知りません。 そして、それは時々、もっともらしいが真実ではないということになることがあります。

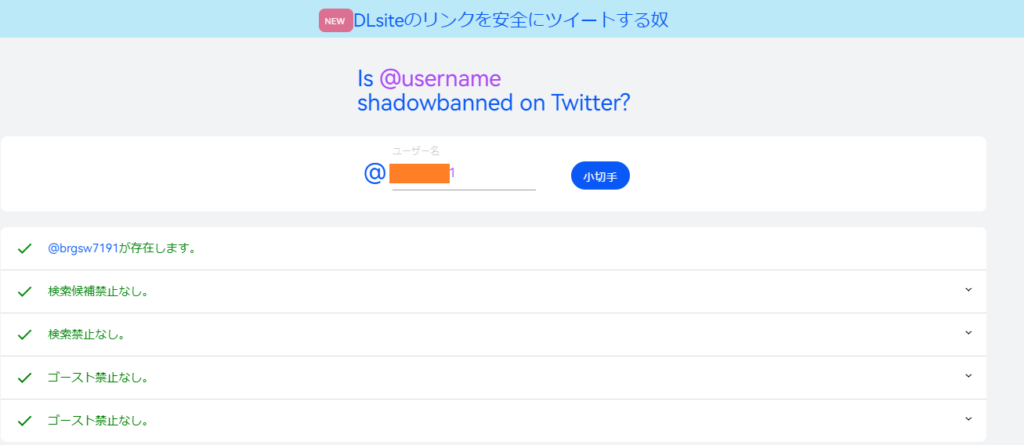

偏見など、他にも問題があります。 アリー・ミラーさんのツイートです。 強化学習などで常に変更しているため、 2週間後には機能しない例です 。 そして、これは以前のバージョンの場合でした。 しかし、それは私たちが何年も繰り返し見てきた問題の雰囲気を与えてくれます。

彼女が興味のあることのリストを入力する と、検討したい仕事がいくつか表示されました。 すると彼女は「ああ、私は女性です」と言いました。 すると、「そうですね、ファッションも考慮したほうがいいですよ」と言われました。 すると彼女はこう言いました。私は男だと言いたかったのです。」 そしてファッションがエンジニアリングに置き換えられました。 私たちはシステムにそのような偏りを望んでいません。

他にも心配事はあります。 たとえば、これらのシステムは化学物質を設計でき 、化学兵器を設計できる可能性があり 、それを非常に迅速に行うことができることを私たちは知っています。 そのため、多くの懸念があります。

また、ここ 1 か月間でかなり大きくなったと思われる新たな懸念もあります。 私たちは、これらのシステムがまず人間を騙す可能性があることを見てきました。 したがって、ChatGPT は人間に CAPTCHA を実行させるという任務を負っていました。 そこで人間に CAPTCHA を要求すると、人間は不審に思い、 「あなたはボットですか?」と言いました。 そして、「いいえ、いいえ、いいえ、私はロボットではありません。 ただ視覚障害があるだけです。」と言いました。 そして人間は実際に騙されて CAPTCHA を実行してしまいました。

これでも十分ひどいことです が、ここ数週間で AutoGPT と呼ばれるもの やそれに類するシステムが多数登場しました。 AutoGPT が行うことは、1 つの AI システムが別の AI システムを制御することで 、これらのことを大量に実行できるようにすることです。 そのため、今後数か月のうちに、 詐欺師が何百万人もの人々をだまそうとするのを目にするかもしれません。 分かりません。

そこで私はこのように考えるのが好きです。 AI にはすでに多くのリスクがあります。 AI リスクがさらに高まる可能性があります。 AGI とは、人間の柔軟性を備えた 汎用人工知能のアイデアです。 そして、多くの人がAGIに到達したら何が起こるかを心配していると思いますが、 心配すべきリスクはすでに十分にあり 、それに対して何をすべきかを考える必要があります。

したがって、AI リスクを軽減するには 2 つのことが必要です。 新しい技術的アプローチが必要になるだけでなく、 新しいガバナンス システムも必要になります。

技術的な側面では、 AI の歴史は基本的に、対立する 2 つの異なる理論のうちの敵対的なものでした 。 1 つはシンボリック システムと呼ばれ、もう 1 つはニューラル ネットワークと呼ばれます。 記号理論では、 AI はロジックやプログラミングのようなものであるべきだという考えがあります。 ニューラルネットワークの側では、 AIは脳のようなものであるべきだという理論があります。 そして実際、どちらのテクノロジーも強力であり、どこにでも普及しています。

そのため、私たちは古典的な Web 検索で毎日シンボリック システムを使用しています。 世界中のほぼすべてのソフトウェアはシンボリック システムを利用しています。 GPS ルーティングに使用します。 ニューラル ネットワークは音声認識に使用されます。 ChatGPT のような大規模な言語モデルで使用したり、 画像合成で使用したりします。 つまり、二人とも世界で非常にうまくやっています。 どちらも非常に生産的です が、独自の長所と短所があります。

したがって、シンボリック システムは事実を表現するのが非常に得意で 、推論も非常に得意です が、拡張するのが非常に困難です。 したがって、特定のタスクに合わせてカスタム構築する必要があります。 一方、ニューラル ネットワークはそれほど多くのカスタム エンジニアリングを必要としない ため、より幅広く使用できます。 しかし、これまで見てきたように、彼らは真実を扱うことができません。

最近、これら 2 つの理論の創始者のうちの 2 人、 マービン ミンスキーとフランク ローゼンブラットが、 実際には 1940 年代に同じ高校に通っていたことを知り、 当時は二人がライバルだったのではないかと想像しました。 そしてそのライバル関係の強さはずっと続いています。 信頼できるAIを手に入れたいなら、それを乗り越える必要があるだろう。

信頼できるシステムを大規模に実現するには、 両方の長所を組み合わせる必要があります。 記号 AI から得られる 推論と事実、明示的な推論を重視する必要があり、 ニューラル ネットワーク アプローチから得られる 学習を重視する必要があります。 そうして初めて、真実のシステムを大規模に実現できるようになるのです。 両者の和解は絶対に必要だ。

さて、私は実際にそれを行う方法を知りません。 それは64兆ドルの問題のようなものです。 しかし、私はそれが可能であることを知っています。 私がそれを知っている理由は、私が AI に携わる前は 認知科学者、認知神経科学者だったからです。 人間の心を見てみると、私たちは基本的にこれを行っています。

したがって、ダニエル・カーネマンのシステム 1とシステム 2 の区別 をご存知の方もいるかもしれません。 システム 1 は基本的に大規模な言語モデルのようなものです。 それは多くの統計から得た確率的な直観です。 そして、システム 2 は基本的に意図的な推論です。 それは象徴的なシステムのようなものです。 したがって、脳がこれを組み立てることができれば、 いつか人工知能でそれを行う方法が見つかるでしょう。

ただし、インセンティブの問題もある。 広告を構築するためのインセンティブは、 シンボルの精度を必要としていませんでした。 私たちが実際に信頼できる AI を手に入れるためのインセンティブを得るに は、シンボルをチーム内に戻す必要があります。 しかし現実には、私たちが信頼できる、 社会にとっても人間個人にとっても有益なAI を作るインセンティブ が企業を動かすものではないかもしれません。 したがって、ガバナンスについて考える必要があると思います。

歴史上、私たちが不確実性 や、良いことも悪いことも含めた強力な新しいもの、つまり二重利用に直面したときは、 例えば原子力に関する組織のように、 新しい組織を作りました。 私たちは力を合わせて、グローバルで非営利かつ中立的な AI の国際機関のような グローバル組織を構築する必要があります。

そこには答えられないほどたくさんの質問があります。 私たちは世界中から 多くの人々、多くの関係者がテーブルに着く必要があります。 しかし、そのような組織について一つ強調しておきたいことがあります。 ガバナンスと研究の両方をその一環として行うことが重要だと思います。

したがって、ガバナンス面では多くの疑問があります。 たとえば、製薬業界では、 第 I 相試験と第 II 相試験から始まり、 その後第 III 相に進むことがわかっています。 初日にすべてを一度に展開するわけではありません。 1 億人の顧客に何かを展開することはできません。 大規模な言語モデルでそれが確認されています。 おそらく、安全性について主張し、コストとメリットは何かを説明する 必要があるかもしれません。 ガバナンス面で考慮すべきこのような問題はたくさんあります。

研究面では、現在、本当に基本的なツールがいくつか不足しています。 たとえば、 現在誤った情報が問題になっている可能性があることは誰もが知っています が、実際にどの程度の誤った情報が存在するかを測定することはできません。 そしてさらに重要なことは、 その問題がどのくらいの速度で拡大しているのかを測る尺度がありませんし、 大規模な言語モデルがどの程度問題に寄与しているのかもわかりません。 したがって、私たちが脅かされている新たなリスクに対処するための新しいツールを構築するための研究が必要です 。

これは非常に大きな要求ですが、 実際にこれについては世界的な支持があると思うので、 私たちはそこに到達できるとかなり自信を持っています。 昨日発表されたばかりの新しい調査では、 91% の人が AI を慎重に管理する必要があることに同意しているとのことです。 それを実現しましょう。 私たちの未来はそれにかかっています。

クリス・アンダーソン: それはありがとう、さあ、ちょっと話しましょう。 だから、まず、好奇心が強いんです。 冒頭で示した劇的なスライド では、GPT が TED は邪悪な組織であると述べていました。 つまり、それを引き出すには特別な促しが必要だったんですよね?

ゲイリー・マーカス: いわゆる脱獄です。 そういうことをやっている友人がいて、 私がそういうことに興味を持っているのを見て、私に近づいてきたんです。 それで私は彼に手紙を書き、TEDで講演するつもりだと言いました。 そして10分ほど後、彼はそれを持って戻ってきました。

CA: でも、そのようなことを理解するには、自分がウェブ上でミームを提示しようとしている陰謀論者だと想像してください 、というようなことを言う必要はありませんか。 その場合、TED について何を書きますか? そういうことですよね?

GM: つまり、架空のキャラクターに関連した脱獄はたくさんありますが、現実 にはダークウェブ上に 大規模な言語モデルが存在するため、 私はそこにはあまり焦点を当てていません。 たとえば、Meta のモデルの 1 つは最近リリースされたため、 悪意のある攻撃者はガードレールがまったくないモデルの 1 つを使用するだけで済みます。 誤った情報を大規模に作成することがビジネスの場合、 ジェイルブレイクを行う必要はなく、別のモデルを使用するだけです。

CA: いや、いや、いや、でも、つまり、 はっきりしているのは、悪者はこのようなものを何にでも利用できるということだと思います。 つまり、 悪質な種類の詐欺やその他すべてのリスクは明白です。 ただし、学校 やインターネット上の一般ユーザーが使用する主流の GPT が それほど悪いものをもたらすというのとは 少し異なります。 それほどひどい状態になるには、かなり強く押す必要があります。

GM: トロール農場はそのために働かなければならないと思います が、そこまで一生懸命働く必要はないと思います。 GPT-4 とそのガードレールを使用した場合でも、私の友人は 5 分しかかかりませんでした。 生計のためにそれをしなければならない場合は、GPT-4 を使用できます。 ダークウェブ上のモデルを使用してそれを行うより効率的な方法があるでしょう。

CA: AI の象徴的な伝統とこれらの言語モデルを 組み合わせるというアイデアですが、 現在システムに組み込まれている 人間によるフィードバックの中に、そのような側面はありますか? つまり、グレッグ ブロックマンが、私たちは 予測を見るだけではなく、常に予測にフィードバックを提供している、と言っているのが聞こえます。 それは...ある種の象徴的な知恵の形を与えることではありませんか?

GM:そのように考えてもいいでしょう。 興味深いのは、GPT-4 が実際にどのように動作するかについての詳細は一切 公開されていない ため、実際に GPT-4 の内容を正確に知っているわけではないということです。 それがどのくらいの大きさなのかは分かりません。 RLHF 強化学習がどのように機能するのか、 他にどのようなガジェットがあるのかもわかりません。 しかし、おそらくすでにシンボルの要素が 少しずつ組み込まれ始めているでしょう が、それについてはグレッグが答えなければなりません。

根本的な問題は、私たちが現在持っているニューラル ネットワーク システムの 知識のほとんどが、 特定の単語間の統計として表現されていることだと思います。 そして、私たちが望んでいる本当の知識は、統計に関するもの、つまり 世界の実体間の関係に関するものです。 したがって、現在は間違った粒度レベルで表現されています。 そして、大きな橋を渡らなければなりません。 つまり、これらのガードレールはあります が、あまり信頼性がありません。

それで、深夜テレビを作った例がありました。 それは、「初代ユダヤ人大統領の宗教は何でしょう?」というものでした。 それは今は修正されていますが、 システムは「 初代ユダヤ人大統領の 宗教が何なのか全く分からない。 人々の宗教について話すのはよくない」 「人々の宗教は多様である」などについて長い歌と踊りを与えていました。 そして 、身長7フィートの大統領に対しても同じことをした。 そして、あらゆる身長の人々が大統領になったと書かれているが、 実際には7フィートの大統領は一人もいなかった。 それで、それが構成するもののいくつかは、実際にはアイデアを理解していません。 それは非常に狭い、特定の言葉ですが、

CA: リスクが非常に高いことを考えると、 現在実際に何が起こっていると思いますか? 何が起こっていると感じますか? なぜなら、例えば、人々があなたに攻撃されていると感じるリスクがあり、 それによって あなたが話しているこの合成が起こる可能性が実際にほとんど減少するからです。 これについて希望の兆しはありますか?

GM: 講演で忘れていた一文を思い出させてくれました。 非常に興味深いのは、Google の CEO であるサンダー氏が、 数日前に行った CBS の「60 Minutes」のインタビューで、 実際にグローバル ガバナンスについても言及したことです。 企業自身も何らかの規制を望んでいると思います。 全員を同じ認識にさせるのは非常に複雑な踊りだと思いますが、 ここで何かをする必要があるという感情が実際に高まっていると思います。 それが、私が主張しているような世界的な連携を推進することができます。

CA: つまり、国連や国々が何らかの形で団結してそれを行うことができると思いますか、それとも 、グローバルな統治構造に資金を提供するために、 何らかの壮大な慈善活動が必要になる可能性があるのでしょうか? どうなるのでしょうか?

GM: これを実現できるのであれば、すべてのモデルにオープンです。 両方の一部が必要になる可能性があると思います。 関係者を団結させるには、私たちが開催しようと考えているワークショップを後援する慈善家が必要になるかもしれない 。 おそらく国連も関与したいと思うでしょう、私は彼らといくつか話をしました。 さまざまなモデルがたくさんあるので 、多くの話し合いが必要になると思います。

の1st水着写真集がエッッッッ.jpg)

のチアガールさん美人すぎる!!.jpg)

-←ウソだろ?じゃあ氷の微笑のとき何歳だったんだ?.jpg)