人工知能(AI)は現代社会において大きな注目を浴びていますが、その危険性についての誤解や誤った信念も多く存在します。本記事では、TEDトーク「AI is Dangerous, but Not for the Reasons You Think」(AIは危険だが、思っている理由とは異なる)から得られる洞察をもとに、AIの危険性について詳しく探求していきます。AIが持つ実際のリスクとそれに対する適切な対策について考えてみましょう。

1. AIの危険性に関する一般的な誤解

多くの人がAIの危険性について議論する際、主に以下の誤解に陥りがちです。

1.1. 意思を持つAIによる脅威

多くのSF映画や小説に登場するような、自己意識を持つAIによる脅威は、現実のAIには当てはまりません。現時点では、AIはプログラムに従って動作し、自己意識や意図を持つことはありません。

1.2. AIの悪用による脅威

AIはツールであり、その使用方法によって危険性が変わります。AI自体が悪意を持つのではなく、人間がAIを悪用することによって危険性が発生します。例えば、AIを利用してフェイクニュースを生成することができ、社会的混乱を引き起こす可能性があります。

2. 実際のAIの危険性

AIの危険性は、主に以下の点に関連しています。

2.1. バイアスと差別

AIは訓練データから学習し、そのデータに含まれるバイアスや差別的な要素を取り込むことがあります。これにより、AIシステムが偏見を持った意思決定を行う可能性があります。例えば、人種や性別に基づいた差別的な結果が生まれることがあります。

2.2. プライバシーの侵害

AIは大量のデータを処理し、個人のプライバシーに関する懸念が浮上しています。個人情報の収集や分析にAIが利用され、プライバシー侵害が発生する可能性があります。

2.3. 自動化による雇用の影響

AIの自動化能力は労働市場に大きな影響を与える可能性があります。特定の業種や職種が自動化されることにより、雇用機会が減少する可能性があるため、これに対処する必要があります。

3. AIの危険性に対する対策

AIの危険性に対する適切な対策を考えることが重要です。

3.1. バイアスの監視と修正

AIシステムの訓練データからのバイアスを監視し、修正する仕組みを導入することが必要です。公平性を確保し、差別的な結果を防ぐための取り組みが必要です。

3.2. プライバシー保護の強化

AIを使用する際には、個人情報の適切な保護措置を講じる必要があります。データ収集と利用に関する規制を強化し、プライバシーの侵害を防ぐための法律や規制を整備することが不可欠です。

3.3. 教育とスキルの向上

AIによる自動化が進む中で、労働者のスキルや職業教育を強化し、雇用機会の確保を支援する必要があります。新たな技術に適応し、変化に適応できる能力を育むことが大切です。

結論

AIは現代社会において重要な役割を果たしていますが、その危険性について正確に理解し、適切な対策を講じることが不可欠です。AIのバイアス、プライバシー、雇用への影響に対処するために、個人、企業、政府は協力し、持続可能な未来を築くための取り組みを行うべきです。AIは危険ではありますが、その危険性に対処することで、私たちはより良い社会を築く手助けをすることができるでしょう。

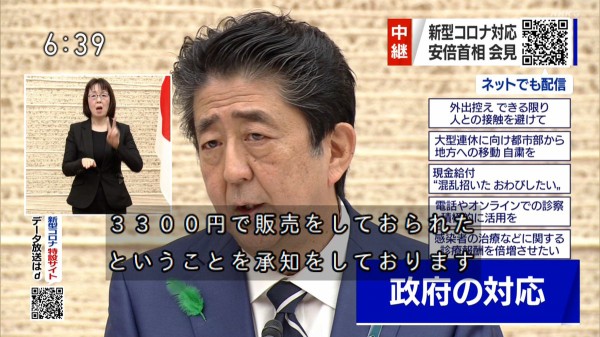

私は 10 年以上 AI 研究者として働いてきました。

そして数か月前、これまでのキャリアの中で最も奇妙なメールを受け取りました。

見知らぬ人が私に手紙を書いてくれた

私のAIでの仕事が人類を滅ぼすことになる、と。

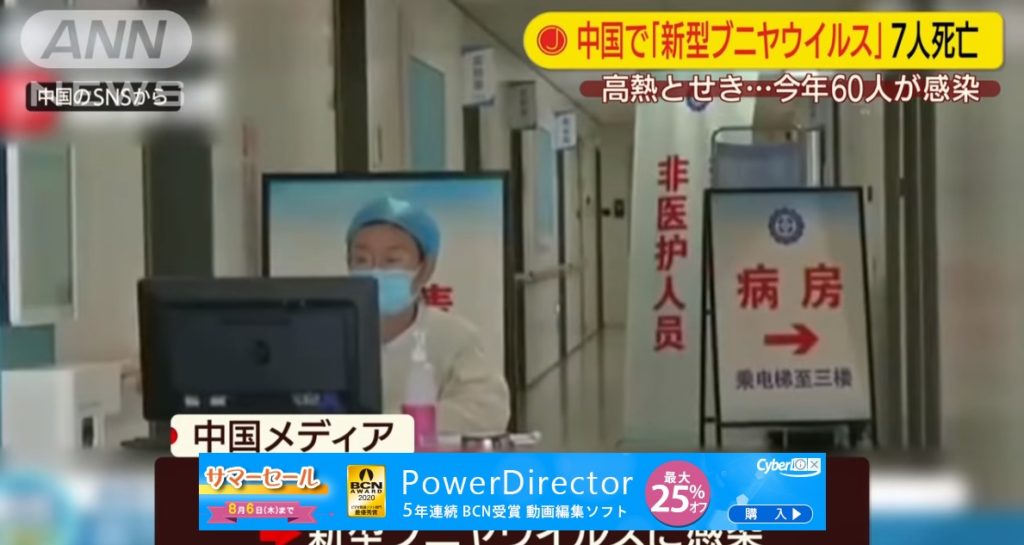

わかりました、AI、今とても暑いです。

ほぼ毎日のようにニュースの見出しに載っていますが、

時には本当に素晴らしいことのせいで

薬用の新しい分子を発見するような

あるいは、白いフグのコートを着たあのドープな教皇。

しかし、見出しが本当に暗い内容になることもありました。

あの男に妻と離婚すべきだと言うチャットボットみたいに

または、群衆に喜ばれるレシピを提案する AI ミールプランナー アプリ

塩素ガスを使用しています。

そしてその背景には、

終末のシナリオについてはたくさんの話を聞いてきましたが、

実存的リスクと特異点、

手紙を書いたり、イベントを企画したりする

そうならないようにするために。

今はAIが社会に与える影響を研究する研究者です。

10年後、20年後はどうなっているのか分かりませんが、

そして誰も実際にはそうしません。

しかし、私が知っているのは、現在かなり厄介なことが起こっているということです。

なぜなら、AIは孤立して存在しているわけではないからです。

それは社会の一部であり、人々と地球に影響を与えます。

AI モデルは気候変動に寄与する可能性があります。

トレーニング データにはアーティストが作成したアートや書籍が使用されています

および著者の同意なしに。

そして、その展開はコミュニティ全体を差別する可能性があります。

しかし、私たちはその影響の追跡を開始する必要があります。

私たちは透明性を保ち、それらを開示してツールを作成し始める必要があります

人々がAIをよりよく理解できるように、

できれば将来の世代の AI モデルが

より信頼性が高く、持続可能なものになるでしょう。

もしあなたがそのことに興味があるなら、私たちを殺す可能性は低いかもしれません。

しかし、まずは持続可能性から始めましょう。

なぜなら、AI モデルが住んでいる雲は、実際には金属やプラスチックでできているからです。

そして膨大なエネルギーによって動かされます。

そして、AI モデルをクエリするたびに、地球にコストがかかります。

昨年、私は BigScience イニシアチブに参加しました。

千人の研究者を集めた

世界中からブルームを生み出すために、

ChatGPT のような、最初のオープンな大規模言語モデル、

ただし、倫理、透明性、同意を重視します。

ブルームの環境への影響を調べた私が主導した研究

トレーニングするだけでも同じくらいのエネルギーを消費することがわかりました

年間30軒ほど

25トンの二酸化炭素を排出し、

これは車で地球を5周するようなものです

誰かがこのモデルを使ってノックノックジョークを言えるようにするためです。

そして、これは大したことではないように思えるかもしれませんが、

しかし、他の同様の大規模言語モデルでは、

GPT-3のように、

20倍の炭素を排出します。

しかし問題は、テクノロジー企業はこのことを測定していないということです。

彼らはそれを公開していません。

そして、これはおそらく氷山の一角にすぎません。

たとえそれが溶けたものであっても。

そして近年、AI モデルのサイズが膨れ上がっているのが見られます。

なぜなら、AI の現在の傾向は「大きいほど良い」だからです。

しかし、なぜそうなるのかについては私に話さないでください。

いずれにしても、特に大規模な言語モデルを見てきました。

過去 5 年間で 2,000 倍の規模に成長しました。

そしてもちろん、環境コストも同様に増加しています。

私が主導した最近の研究では、より小さな、

大規模な言語モデルのより効率的なモデル

同じ作業で 14 倍の二酸化炭素を排出します。

ノックノックジョークを言うようなものです。

そして、これらのモデルを携帯電話や検索エンジンに組み込むと、

スマート冷蔵庫やスマートスピーカー、

環境コストは実際に急速に積み重なっています。

したがって、将来の存続リスクに焦点を当てるのではなく、

現在の具体的な影響について話しましょう

そして、これらの影響を測定し、軽減するために作成できるツール。

私はCodeCarbonの作成に協力しました。

AI トレーニング コードと並行して実行されるツール

消費するエネルギー量を推定するもの

そしてそれが排出する炭素の量。

このようなツールを使用すると、情報に基づいた選択を行うのに役立ちます。

持続可能性が高いという理由で、あるモデルを他のモデルよりも選択するなど、

または再生可能エネルギーに AI モデルを導入する、

排出量を大幅に削減できます。

でも、他のことについて話しましょう

持続可能性以外にも AI の影響があるからです。

たとえば、アーティストや作家にとっては本当に大変なことです

彼らのライフワークが AI モデルのトレーニングに使われていることを証明するため

彼らの同意なしに。

そして、誰かを訴えたい場合は証拠が必要になりますよね?

そこで、アーティストによって設立された団体 Spawning.ai は、

「Have I Been Training?」という非常にクールなツールを作成しました。

これらの膨大なデータセットを検索できます

彼らがあなたに何を持っているかを見るために。

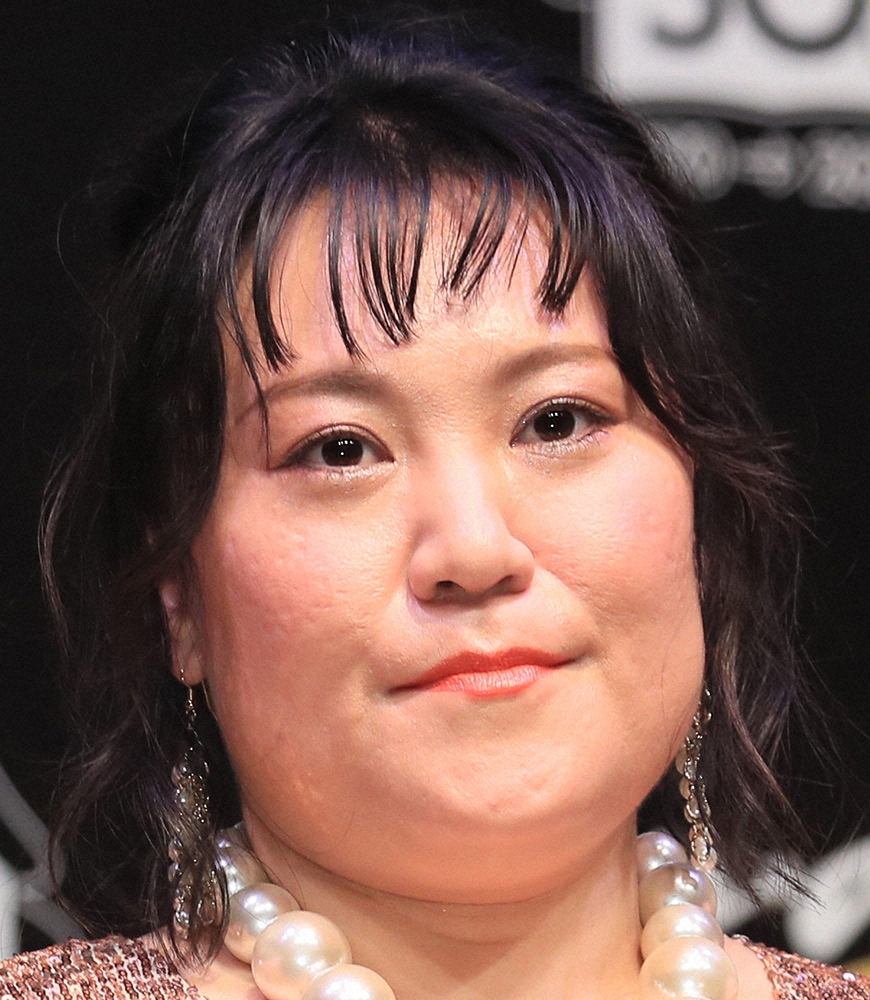

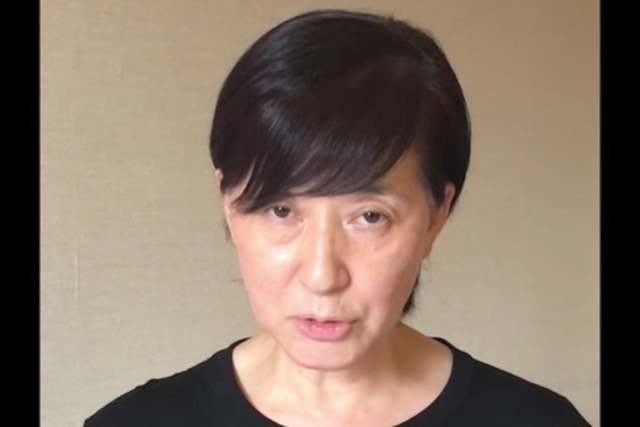

今では認めますが、私は好奇心を持っていました。

LAION-5Bを検索してみたところ、

これは画像とテキストの巨大なデータセットです

そこに私の画像がないかどうかを確認してください。

さて、最初の 2 つの画像ですが、

これは私が講演したイベントからの抜粋です。

しかし、残りの画像はどれも私ではありません。

おそらくサーシャという名前の他の女性のものでしょう

自分の写真をインターネット上に公開する人。

おそらくこれでその理由が説明できるでしょう。

画像生成モデルをクエリするとき

サーシャという名前の女性の写真を生成するには、

ビキニモデルの画像をよく目にします。

腕が二本ある場合もありますが、

腕が3本ある場合もありますが、

しかし、彼らはほとんど服を着ていません。

あなたや私のような人にとっては興味深いかもしれませんが、

これらのデータセットを検索するには、

カーラ・オルティスのようなアーティストにとって、

これは、彼女のライフワーク、彼女の芸術作品が、

彼女の同意なしにAIモデルのトレーニングに使用され、

そして彼女と2人のアーティストはこれを証拠として使用しました

AI企業に対して集団訴訟を起こす

著作権侵害のため。

そしてつい最近では --

そしてつい最近、Spawning.ai は Hugging Face と提携しました。

私が働いている会社、

これらのデータセットを作成するためのオプトインおよびオプトアウトのメカニズムを作成します。

人間が作った芸術作品は食べ放題であってはいけないから

AI 言語モデルのトレーニング用。

最後に話したいのは偏見についてです。

おそらくこれについてよく耳にするでしょう。

正式に言えば、AI モデルがパターンと信念をエンコードするときです。

固定観念や人種差別、性差別を表す可能性があります。

私のヒーローの一人であるジョイ・ブオラムウィニ博士は、これを直接経験しました。

AI システムが自分の顔さえ検出しないことに彼女が気づいたとき

彼女が白い色のマスクをしていなければ。

さらに深く掘り下げていくと、一般的な顔認識システムが

白人男性と比較して、有色人種の女性の方がはるかに悪かった。

そして、このような偏ったモデルが法執行機関に導入されると、

これは冤罪、さらには不法投獄につながる可能性があります。

私たちはここ数か月間、複数の人に同じことが起こっているのを目撃しました。

たとえば、ポーチャ・ウッドラフはカージャックで不当に告発された

妊娠8ヶ月のとき

AI システムが彼女を誤って識別したためです。

しかし、悲しいことに、これらのシステムはブラックボックスです。

そして、その作成者ですら、なぜそのようなやり方で仕事をしているのかを正確に言うことができません。

たとえば、画像生成システムの場合、

法医学スケッチの生成などのコンテキストで使用される場合

犯人の説明に基づいて、

彼らはそれらすべての偏見を受け入れ、それを吐き出します

危険な犯罪者、テロリスト、ギャングメンバーなどの用語の場合、

もちろんそれは超危険です

これらのツールが社会に導入されるとき。

これらのツールをよりよく理解するには、

私は Stable Bias Explorer というツールを作成しました。

これにより、画像生成モデルの偏りを調べることができます

職業というレンズを通して。

ですから、頭の中で科学者を思い浮かべてみてください。

私を見ないでください。

何が見えますか?

同じようなことがたくさんありますよね?

メガネと白衣を着た男性。

そして、それらのどれも私に似ていません。

そして問題は、

これらのさまざまな画像生成モデルをすべて調べたということです

そして同じことをたくさん見つけました:

白さと男らしさの重要な表現

私たちが調査した150の職業すべてにわたって、

たとえ現実世界と比べても、

米国労働統計局。

これらのモデルは弁護士を男性として示しています。

そしてCEOはほぼ100パーセント男性です。

たとえ彼ら全員が白人男性であるわけではないことは誰もが知っています。

そして悲しいことに、私のツールはまだ法案作成に使用されていません。

しかし私は最近、ジェンダーバイアスに関する国連のイベントでそれを発表しました

あらゆる階層の人々のためのツールをどのように作成できるかの例として、

コーディングの仕方がわからない人でも、

私たちは専門職を利用しているため、AI と関わり、より深く理解することができます。

ただし、興味のある用語はどれでも使用できます。

そして、これらのモデルが展開されるにつれて、

私たちの社会の構造そのものに織り込まれており、

私たちの携帯電話、ソーシャルメディアフィード、

私たちの司法制度や経済にも AI が組み込まれています。

そして、AI がアクセスしやすい状態を維持することが非常に重要です

そうすることで、それがどのように機能するのか、いつ機能しないのかを知ることができます。

そしてバイアスのような本当に複雑なものに対する単一の解決策はありません

著作権や気候変動など。

しかし、AI の影響を測定するツールを作成することで、

彼らがどれほど悪いのかを理解できるようになります

そして、私たちが進みながらそれらに対処し始めます。

社会と地球を守るためにガードレールを作り始めましょう。

そして、この情報を入手したら、

企業は次のような目的でそれを使用できます。

OK、より持続可能であるため、このモデルを選択します。

このモデルは著作権を尊重しているためです。

法律を作成するために本当に情報が必要な議員、

これらのツールを使用して新しい規制メカニズムを開発できます

AI が社会に導入される際のガバナンス。

そして、あなたや私のようなユーザーはこの情報を使用できます

信頼できる AI モデルを選択するため、

当社を虚偽表示したり、当社のデータを悪用したりしないこと。

でもそのメールに何て返信したんだろう

私の仕事が人類を滅ぼすと言ったのですか?

AI の将来の存続リスクに焦点を当てると言いました

それは現状から気をそらすものであり、

非常に具体的な影響

そして私たちが今、あるいは昨日やるべき仕事、

これらの影響を軽減するために。

確かに、AI は急速に進歩していますが、まだ取引が完了したわけではありません。

私たちは歩きながら道を築いています。

そして、どのような方向に進みたいかを一緒に決めることができます。

.jpg)

:1-ライドコミックス-薬味紅生姜 ―-夢幻の世界で繰り広げられる魅惑と冒険の物語.jpg)

とみられる男の身柄確保-818x1024.jpg)